Das User Interface der Zukunft

Künstliche Intelligenz reagiert auf Emotionen

Dank künstlicher Intelligenz lernen Geräte und Programme, auf Emotionen der Nutzer zu reagieren. Dies wird das User Interface der Zukunft dramatisch verändern.

Text: Hansjörg Honegger,

E-Reader sind eine praktische Sache: Leicht, jede Menge Bücher speicherbar, einige sind sogar permanent online. Nur lesen und verstehen muss man die Texte noch selbst –bis jetzt. Mithilfe künstlicher Intelligenz und Methoden zur Analyse von menschlichen Emotionen können E-Reader künftig vielleicht noch viel mehr:

- Die Buchstaben werden bei Ermüdungserscheinungen automatisch etwas grösser.

- Ein zweifelnder Blick auf ein Wort blendet eine Erklärung – oder Übersetzung - ein.

- Lässt die Konzentration nach, wird gleich der gesamte folgende Text etwas einfacher formuliert. All das, damit der Leser möglichst lang dranbleibt.

Das ist – zum Teil – noch Zukunftsmusik. Doch UX-Spezialisten („User Experience“ Anwendererlebnis) haben erkannt: Es reicht heute nicht mehr, den Anwendern eine intuitive Benutzeroberfläche zu präsentieren, die auf bekannten Standards gründet. Wer heute ein Gerät nutzt, hat eine emotionale Erwartungshaltung, die sich laufend verändert. Die Benutzeroberfläche muss künftig mit diesen Erwartungshaltungen mithalten können. Ganz abgesehen davon verlangen beispielsweise Wearables oft eine komplett neue Art Benutzeroberfläche. Und Sprache ist bei weitem nicht der Weisheit letzter Schluss.

Enttäuschungen vorbeugen

IBM stellte in der Studie «The Experience Revolution: Digital Disappointment – Why Some Consumers Aren’t Fans» fest, dass 70 Prozent der Kunden digitaler Angebote unzufrieden sind. Die Enttäuschung in der virtuellen Realität oder bei der automatischen Sprachsteuerung halte sie davon ab, ein zweites Mal mit der Marke in Kontakt zu treten. Bequemlichkeit, rasche Resultate und einfache Prozesse seien entscheidend, um Fan einer Marke zu werden. Sowie natürlich ein attraktiver Preis.

Enttäuschung heisst: Die Erwartungshaltung konnte nicht erfüllt werden. Wie aber soll ein Gerät eine Erwartungshaltung erkennen, die nicht zuletzt von der emotionalen Befindlichkeit des Kunden abhängt? Professor Per Bergamin, Leiter des Instituts für Fernstudien und e-Learning-Forschung (IFeL) in Brig, beschäftigt sich seit Jahren mit dieser Frage. Seine Forschungseinheit «Personalisiertes und adaptives Lernen» hat zum Ziel, den Studenten am Bildschirm individuell angepasstes Lernen zu ermöglichen. «Der Schwierigkeitsgrad des Lernstoffes wird mit unserer Lösung je nach Lernfortschritt des Studenten automatisch angepasst», erklärt Bergamin. Das System im Hintergrund lernt laufend dazu und vermag aus den Antworten des Studenten dessen Wissenstand zu interpretieren. Darauf aufbauend wird der Folgestoff präsentiert.

Bergamin macht ein simples Beispiel: «Die Software kann fragen, wie das Verdampfen von Eis funktioniert. Oder sie kann diese Frage in zehn Einzelfragen aufteilen, die den Studierenden langsam an die richtige Lösung heranführt.» Bisher, so Bergamin, seien die Lernfortschritte mit entsprechenden Fragen eruiert worden. Eine mühsame Angelegenheit, die viel Handarbeit von den Entwicklern erforderte. Jetzt aber, in Phase 2, arbeitet das Briger Forschungsteam an einem Ansatz, der auch menschliche Emotionen beizieht. «Es gibt Menschen, die ungern Fragen beantworten, diese Studenten dürfen nicht benachteiligt werden», betont Bergamin. Gesichtsausdrücke sollen über den Wissenstand der Studenten Auskunft geben. Schaut jemand fragend, verzweifelt, begeistert? Die Software interpretiert diese Gefühle und zeigt den entsprechenden Stoff. Voraussetzung ist natürlich, dass der Studierende über die entsprechende Hardware verfügt.

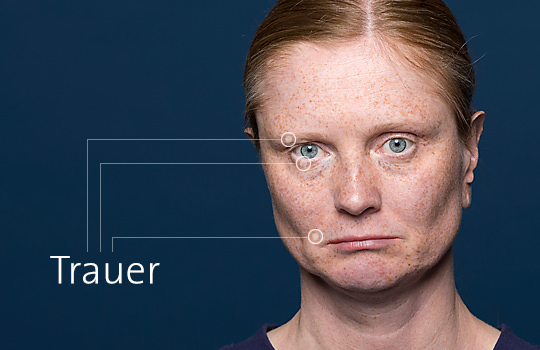

Sonar: Effizienter als klassische Reportings

Aber drücken Menschen unterschiedlicher Kulturen ihre Gefühle denn überhaupt so aus, dass eine Maschine das auch erkennen kann? Sofern sich beispielsweise die Gesichtserkennung auf die sieben Basis-Emotionen nach Paul Ekmann beschränkt. sollte das kein Problem sein. Der entsprechende Ausdruck für Freude, Wut, Furcht, Ekel, Traurigkeit, Überraschung, Verachtung und Scham ist jedem Menschen angeboren und lässt sich weltweit identifizieren. Ob die Maschine die Expression im entsprechenden Zusammenhang richtig interpretiert, steht auf einem anderen Blatt. Ist der Student verzweifelt, weil er zum dritten Mal dieselbe dumme Frage beantworten muss, oder ist er es, weil er die Frage auch zum dritten Mal nicht versteht?

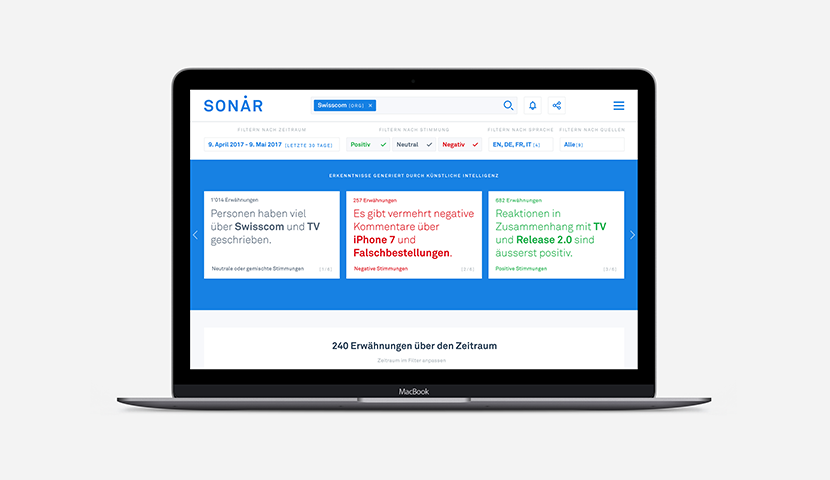

Menschliche Gefühle zu erkennen, ist nicht nur für Benutzeroberflächen zunehmend wichtiger, ihre Bedeutung nimmt auch für Produktentwicklung und Marketing zu. «Sonar», eine von Swisscom entwickelte Lösung, erkennt in Echtzeit, welche Gefühle die Kunden der Firma oder ihren Produkten und Dienstleistungen gegenüber hegen und ob sich irgendwo in der Schweiz etwas zusammenbraut. «In einem Pilotversuch analysieren wir verschiedene öffentliche Internetkanäle», erklärt Marc Steffen, Head of Product Design, Artificial Intelligence & Machine Learning Group bei Swisscom. Das ist an sich noch nichts Neues. Früher aber wurden diese Erkenntnisse in aufwendigen Reportings teilweise manuell zusammengefasst und im besten Fall in einem Dashboard, im schlimmeren Fall in einem Textdokument einigen interessierten Personen weitergereicht.

Heute analysiert Sonar in Echtzeit die Befindlichkeit der Kunden, zeigt an, was geschrieben wird und bewertet zugleich, ob die Trends positiv, negativ oder neutral sind. «Ein Produktmanager kann heute in Sonar nach seinem Produkt suchen, um auf einen Blick festzustellen, ob die entsprechende Kundenstimmung in Social Media und Kommentarspalten eher positiv oder negativ ist und warum», so Marc Steffen. Bis es so weit war, mussten allerdings zuerst rund 10'000 Sätze für das System analysiert und die Formulierungen einem Zustand zugewiesen werden. «Damit lernt Sonar, was in unterschiedlichen Kontexten positive Formulierungen sind, und was negative.»

Die Emotion bestimmt den Inhalt

Die Benutzeroberfläche von morgen wird nicht mehr viel gemein haben mit der Art und Weise, wie wir heute Programme und Informationen nutzen und steuern. Die Erwartungshaltung des Anwenders wird zunehmend darüber bestimmen, was er sieht und wie es ihm präsentiert wird. Möglich wird dies dank künstlicher Intelligenz, die lernt, die Emotionen des Anwenders – bzw. des Kunden - in Stimme, Gesicht und geschriebenem Wort zu deuten. Dies wird zu Diskussionen führen: Will der Anwender überhaupt, dass ihm der Anbieter quasi in den Kopf schaut?

Per Bergamin betont, dass es heute bereits Geräte für relativ wenig Geld auf dem Markt gibt, die unter anderem auch Gehirnaktivitäten interpretieren können. Doch für ihn ist klar, dass die Selbstbestimmung oberstes Gebot ist: «Der Einfluss unserer Lern-Software nimmt schon heute mit zunehmendem Wissenstand des Lernenden automatisch ab und wird statt anleitend eher unterstützend, beispielsweise mit zusätzlichen Informationen, die er bei Bedarf nutzen kann.» Wo die Grenze gezogen wird, muss sich noch weisen. Für Marc Steffen von Swisscom ist aber klar: «Hier braucht es absolute Transparenz und letztlich auch die Wahlfreiheit des Nutzers. Er muss zu jeder Zeit wissen, was der Anbieter tut und sich immer auch dagegen entscheiden können.»

Weiterführende Informationen

Beware emotional robots: Giving feelings to artificial beings could backfire, study suggests: Gerade beim Einsatz von Chatbots ist die Art der Konversation entscheidend. Tiefe Emotionen aufseiten der Maschine wirken verstörend.

Amazon Working on Making Alexa Recognize Your Emotions: Alexa soll erkennen, wenn der Anwender verärgert ist und sich dann entschuldigen. Das wäre mal was ganz Neues bei Computern.

Sonar erkennt Kundenstimmung

Sonar, ein von Swisscom entwickeltes System, sammelt Kundenstimmen über verschiedene Kanäle, so etwa aus Twitter, den Kommentaren von Zeitungswebsites, RSS-Feeds oder den Service Desk. Positive, negative oder neutrale Inhalte – Sonar analysiert automatisch die Stimmung. Ausserdem erkennt das System Trends und Themen oder fasst Kundenfeedbacks in wenigen Sätzen zusammen. Sonar ermöglicht es zu erkennen, wie die Marke von den Kunden erlebt wird. Und als übersichtliche Webapplikation hilft es den Mitarbeitern, die Kunden besser zu verstehen und auf Daten fundierende Entscheidungen zu treffen.